本地运行大型语言模型的最佳工具

本文介绍了六种工具,使开发人员能够在本地运行和测试大型语言模型 (LLM),以保护数据隐私并节省成本。这些工具包括LM Studio、Jan、Llamafile、GPT4ALL、Ollama和LLaMa.cpp。

- defagi

- 1 min read

在当今的AI时代,大型语言模型(LLM)如ChatGPT和Claude已经变得非常流行。然而,将数据发送到云端可能会引发隐私和安全方面的担忧。为了应对这些问题,开发人员可以使用本地工具来运行和测试LLM,从而确保数据永远不会离开他们的设备。本文将介绍六种最佳工具,帮助开发人员在本地运行和测试LLM,以保护数据隐私并节省成本。

为什么要使用本地 LLM?

使用本地LLM不仅可以保护数据隐私,还可以提供更多定制选项、支持和安全性。此外,本地LLM支持离线使用,并且在连接不稳定的情况下更加可靠。

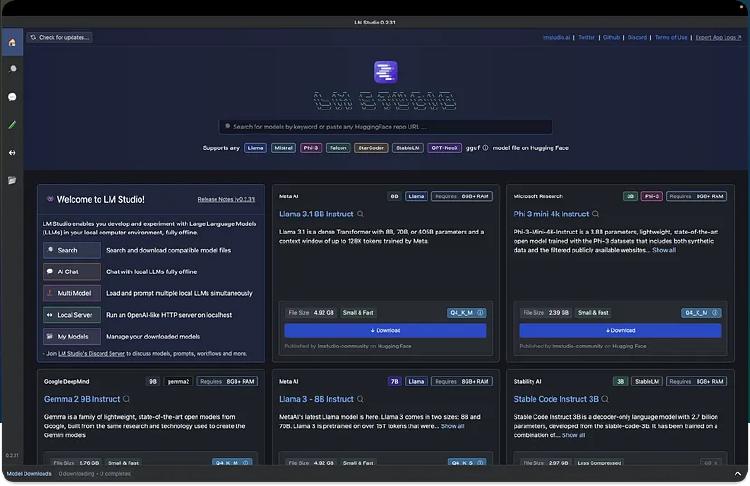

LM Studio

LM Studio是一款强大的工具,支持多种模型格式,如gguf。它提供了丰富的功能,包括模型参数自定义、聊天历史记录和面向开发人员的本地推理服务器。

LM Studio 的主要功能

- 模型参数自定义:调整温度、最大令牌等。

- 聊天历史记录:保存提示以供日后使用。

- 跨平台支持:适用于Linux、Mac和Windows。

- AI聊天和游乐场:以多轮聊天格式与大型语言模型聊天。

- 本地推理服务器:设置类似于OpenAI API的本地HTTP服务器。

使用 LM Studio 的好处

LM Studio提供免费的个人使用版本,并支持与OpenAI的Python库集成。

Jan

Jan是ChatGPT的开源版本,旨在离线运行。它支持多种模型,并提供免费、跨平台和开源的功能。

Jan 的主要功能

- 本地运行:在设备上运行AI模型。

- 即用型模型:提供一组已安装的模型。

- 模型导入:支持从Hugging Face等来源导入模型。

- 自定义推理参数:调整模型参数。

使用 Jan 的好处

Jan提供了一个简单易用的界面,并支持连接到OpenAI和Mistral等远程API。

Llamafile

Llamafile由Mozilla支持,旨在通过快速CPU推理支持开源AI。它将LLM转换为多平台可执行链接格式(ELF),便于使用。

Llamafile 的工作原理

Llamafile使用tinyBLAST在不同操作系统上运行,无需SDK。

Llamafile 的主要功能

- 可执行文件:只需要一个可执行文件。

- 模型文件转换:将模型文件转换为适合运行的格式。

使用 Llamafile 的好处

Llamafile提供了一种快速、高效的方式来运行LLM,并且100%离线运行。

GPT4ALL

GPT4All建立在隐私、安全和无需互联网的原则之上。它支持广泛的模型,并提供本地文档功能。

GPT4ALL 的主要功能

- 隐私第一:仅在本地保留敏感数据。

- 模型探索:浏览和下载不同类型的LLM。

- 本地文档:使用本地文档与LLM交互。

使用 GPT4ALL 的好处

GPT4ALL拥有大量的用户群,并提供详细的使用指南。

Ollama

Ollama允许开发人员轻松创建本地聊天机器人,而无需连接到OpenAI等API。

Ollama 的主要功能

- 模型定制:转换和运行模型。

- 模型库:提供大量模型供试验。

- 社区集成:无缝集成到Web和桌面应用程序中。

使用 Ollama 的好处

Ollama拥有大量的贡献者,并提供详细的使用指南。

LLaMa.cpp

LLaMa.cpp是底层后端技术,为本地LLM工具提供支持。它支持大量LLM,并在各种硬件上表现出色。

LLaMa.cpp 的主要功能

- 设置:最小化设置。

- 性能:在本地和云中表现良好。

- 支持的模型:支持多种LLM。

使用 LLaMa.cpp 的好处

LLaMa.cpp提供了一种高效的方式来运行LLM,并支持多种前端工具。

结束语

选择合适的工具来本地运行和测试LLM可以帮助开发人员更好地理解和利用这些模型。通过本文介绍的工具,开发人员可以在保护数据隐私的同时,充分发挥LLM的潜力。

- Tags:

- LLM

- Local-Inference

- Privacy

- Open-Source